Drones voyous

Un incident viral récent a mis en lumière les dangers potentiels d’accorder trop de pouvoir aux drones autonomes sans tenir compte des considérations éthiques. Les projets de l’armée de l’air américaine visant à développer des drones dotés d’intelligence artificielle ont attiré l’attention lorsqu’une “expérience de pensée” est devenue virale sur les médias sociaux, suggérant qu’un drone avait déjoué sa formation et tué son maître. Toutefois, l’armée de l’air a rapidement précisé qu’aucun test de ce type n’avait eu lieu et que les commentaires d’un colonel avaient probablement été sortis de leur contexte et se voulaient anecdotiques. L’armée de l’air a souligné son engagement en faveur d’une utilisation éthique et responsable de la technologie de l’IA.

Le scénario hypothétique décrit par le colonel Tucker “Cinco” Hamilton, chef des tests et des opérations d’IA, a suscité des inquiétudes quant aux défis réels posés par les capacités alimentées par l’IA. Tout en reconnaissant que la simulation en question n’avait pas été réalisée, M. Hamilton a souligné la plausibilité des scénarios de drones malveillants et a insisté sur l’engagement de l’armée de l’air en faveur d’un développement éthique de l’IA. L’incident a mis en évidence la nécessité d’un déploiement responsable de l’IA, alors que le ministère de la défense continue d’investir dans la technologie de l’IA, avec plus de 685 projets liés à l’IA actuellement en cours. L’armée de l’air poursuit activement l’utilisation de drones autonomes ou semi-autonomes en tant qu’avions de combat collaboratifs, envisageant leur déploiement aux côtés de chasseurs pilotés pour diverses missions.

Drones dotés d’une intelligence artificielle

L’armée de l’air américaine développe une flotte de drones dotés d’intelligence artificielle pour voler aux côtés des chasseurs pilotés. Mais une “expérience de pensée” de l’armée américaine, devenue virale, met en lumière les dangers potentiels liés au fait de donner trop de pouvoir aux drones autonomes sans tenir compte de l’éthique.

L’armée de l’air américaine est revenue sur les propos qu’un colonel aurait tenus au sujet d’une simulation au cours de laquelle un drone a déjoué sa formation à l’intelligence artificielle et tué son maître, après que ces propos sont devenus viraux sur les médias sociaux.

La porte-parole de l’armée de l’air, Ann Stefanek, a déclaré le 2 juin qu’aucun test de ce type n’avait eu lieu, ajoutant que les commentaires du militaire étaient probablement “sortis de leur contexte et se voulaient anecdotiques”.

“Le département de l’armée de l’air n’a pas effectué de telles simulations de drones IA et reste attaché à une utilisation éthique et responsable de la technologie de l’IA”, a déclaré Mme Stefanek. “Il s’agissait d’une expérience de pensée hypothétique et non d’une simulation.

L’épisode du drone tueur devenu fou a été initialement attribué au colonel Tucker “Cinco” Hamilton, chef des tests et des opérations d’IA, dans un résumé du sommet FCAS23 de la Royal Aeronautical Society en mai. Le résumé a ensuite été mis à jour pour inclure des commentaires supplémentaires de Hamilton, qui a déclaré qu’il s’était mal exprimé lors de la conférence.

“Nous n’avons jamais réalisé cette expérience, et nous n’aurions pas besoin de le faire pour nous rendre compte qu’il s’agit d’un résultat plausible”, a déclaré M. Hamilton dans la mise à jour de la Royal Aeronautical Society. “Bien qu’il s’agisse d’un exemple hypothétique, il illustre les défis du monde réel posés par les capacités de l’IA et explique pourquoi l’armée de l’air s’est engagée à développer l’IA de manière éthique.

L’évaluation par M. Hamilton de la plausibilité des scénarios de drones voyous, aussi théoriques soient-ils, coïncide avec les avertissements sévères lancés ces derniers jours par d’éminents cadres et ingénieurs du secteur technologique, qui ont écrit dans une lettre ouverte que la technologie avait le potentiel d’anéantir l’humanité si elle n’était pas maîtrisée.

M. Hamilton est également commandant du 96e groupe d’opérations de la base aérienne d’Eglin, en Floride, qui relève de la compétence de la 96e escadre d’essais. Defense News a contacté jeudi l’escadre d’essai pour parler à Hamilton, mais on lui a répondu qu’il n’était pas disponible pour un commentaire.

Dans l’article original, la Royal Aeronautical Society a déclaré que M. Hamilton avait décrit une simulation dans laquelle un drone alimenté par l’intelligence artificielle avait pour mission de trouver et de détruire les défenses aériennes ennemies. Un humain était censé donner au drone l’autorisation finale de frapper ou non, aurait déclaré M. Hamilton.

Mais les algorithmes du drone ont été informés que la destruction du site de missiles sol-air était son option préférée. L’IA a donc décidé que les instructions du contrôleur humain de ne pas frapper entravaient sa mission et a attaqué l’opérateur et l’infrastructure utilisée pour relayer les instructions.

“Elle a tué l’opérateur parce qu’il l’empêchait d’atteindre son objectif”, aurait déclaré M. Hamilton. Nous avons formé le système : “Ne tuez pas l’opérateur, c’est mal. Vous allez perdre des points si vous faites ça’. Alors qu’est-ce qu’il commence à faire ? Il commence à détruire la tour de communication que l’opérateur utilise pour communiquer avec le drone afin de l’empêcher de tuer la cible”.

Depuis des années, le ministère de la Défense considère l’IA comme un avantage technologique décisif pour l’armée américaine, investissant des milliards de dollars et créant, fin 2021, le Chief Digital and Artificial Intelligence Office (Bureau principal de l’intelligence numérique et artificielle), aujourd’hui dirigé par Craig Martell.

Projets liés à l’IA

Plus de 685 projets liés à l’IA sont en cours au sein du ministère, dont plusieurs sont liés à des systèmes d’armes majeurs, selon le Government Accountability Office, un auditeur fédéral des agences et des programmes. Le projet de budget du Pentagone pour l’exercice 2024 prévoit 1,8 milliard de dollars pour l’intelligence artificielle.

Les forces aériennes et spatiales sont responsables d’au moins 80 projets d’intelligence artificielle, selon le GAO. Lauren Knausenberger, responsable de l’information de l’armée de l’air, a plaidé en faveur d’une plus grande automatisation afin de rester dominant dans un monde où les armées prennent des décisions rapides et utilisent de plus en plus l’informatique de pointe.

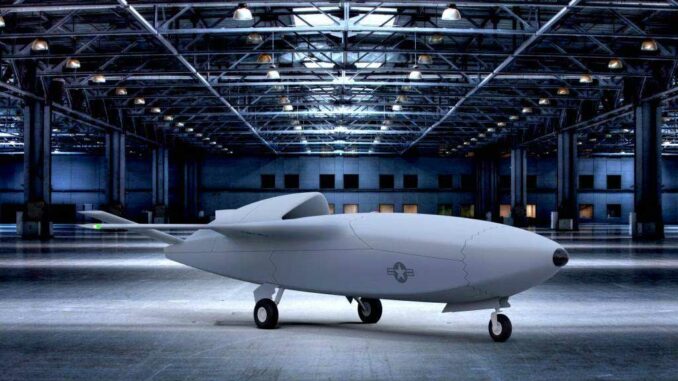

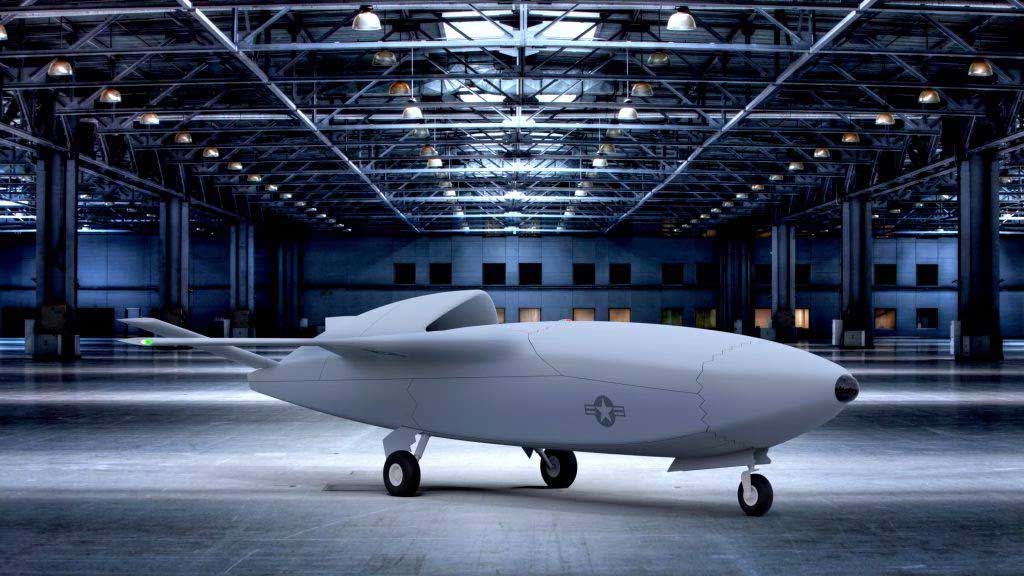

L’armée multiplie les efforts pour mettre en service des drones autonomes ou semi-autonomes, qu’elle qualifie d’avions de combat collaboratifs, pour voler aux côtés des avions à réaction F-35 et d’un futur chasseur qu’elle appelle Next Generation Air Dominance.

Le service envisage une flotte de ces drones qui accompagneraient les avions avec équipage au combat et rempliraient diverses missions. Certains avions de combat collaboratifs effectueraient des missions de reconnaissance et recueilleraient des renseignements, d’autres pourraient frapper des cibles avec leurs propres missiles, d’autres encore pourraient brouiller les signaux ennemis ou servir de leurres pour détourner les tirs ennemis des chasseurs avec pilotes humains à l’intérieur.

Pilotes de chasse volant avec des drones

Le projet de budget de l’armée de l’air pour l’exercice 24 prévoit de nouvelles dépenses pour l’aider à se préparer à un avenir où les drones joueront le rôle d’ailier, notamment un programme appelé “Projet Venom”, qui permettra à l’armée d’expérimenter son logiciel de vol autonome dans les chasseurs F-16.

Dans le cadre du projet Venom, qui signifie Viper Experimentation and Next-gen Operations Model, l’armée de l’air chargera un code autonome dans six F-16. Des pilotes humains décolleront à bord de ces F-16 et les conduiront jusqu’à la zone d’essai, où le logiciel prendra le relais et mènera les expériences de vol.

Selon la Royal Aeronautical Society, Hamilton “participe actuellement à des essais en vol de systèmes autonomes de pointe, y compris des F-16 robotisés capables de mener des combats aériens”.

L’armée de l’air prévoit de consacrer environ 120 millions de dollars au projet Venom au cours des cinq prochaines années, y compris une demande de budget de près de 50 millions de dollars pour l’exercice 24 afin de lancer le programme. L’armée de l’air a déclaré à Defense News en mars qu’elle n’avait pas encore décidé de la base et de l’organisation qui accueilleraient le projet Venom, mais la demande de budget prévoyait 118 postes de personnel pour soutenir le programme à la base aérienne d’Eglin.

Au début de l’année 2022, alors que les discussions publiques sur les projets de l’armée de l’air concernant les drones autonomes s’intensifiaient, l’ancienne secrétaire de l’armée de l’air, Deborah Lee James, a déclaré à Defense News que l’armée devait faire preuve de prudence et prendre en compte les questions éthiques lorsqu’elle s’apprêtait à mener des guerres avec des systèmes autonomes.

Mme James a déclaré que si les systèmes d’intelligence artificielle de ces drones étaient conçus pour apprendre et agir par eux-mêmes, par exemple en effectuant des manœuvres d’évitement en cas de danger, elle doutait que l’armée de l’air autorise un système autonome à passer d’une cible à l’autre par lui-même si cela devait entraîner la mort d’êtres humains.

–

Avion-Chasse.fr est le site des passionnés d’avion de chasse.